Natural Language Generation (NLG) | GPT + RPA + DeepL | Auto-Updating Text | Automatisierte Texte + Produktbeschreibungen

GPT-4: Was du wissen musst und die Unterschiede zu GPT-3

Lesezeit 15 mins | 13.03.2023 | Von: Anne Geyer

ChatGPT ist in aller Munde und verzeichnete in den ersten Tagen nach Veröffentlichung mehr als eine Million Anmeldungen. Noch während der Hype um das Sprachmodell groß ist, hat Entwicklerfirma OpenAI den Nachfolger von GPT-3, GPT-4, herausgebracht. GPT-4 ist eine Weiterentwicklung von GPT-3 bzw. GPT3.5 und bringt eine Reihe neuer Funktionen und Verbesserungen mit sich bringen. Diese machen das Sprachmodell noch leistungsfähiger als all seine GPT-Vorgänger, das zumindest behauptet OpenAI.

Aber was hat es mit GPT-4 auf sich und was kann es wirklich leisten?

Lies im Folgenden, was (bisher) über GPT-4 bekannt ist:

- Was ist GPT und wo findet es Anwendung?

- GPT-3 vs. Data-to-Text – Was ist der Unterschied?

- Was ist GPT-4

- Wie unterscheiden sich GPT-4 und GPT-3?

- Wie sieht GPT-4 aus?

- Anwendungsbereich von GPT-4

- Was ist ChatGPT?

- Was ist der Nutzen von ChatGPT?

- Die Grenzen von ChatGPT

- Wie sieht die Zukunft von GPT aus?

1. Was ist GPT und wo findet es Anwendung?

GPT steht für Generative Pre-trained Transformer und ist ein Sprachmodell, das Deep Learning nutzt, um natürliche Sprache zu erzeugen. Die NLP-Architektur (Natural Language Processing) wurde von OpenAI entwickelt. Dabei handelt es sich um ein von Elon Musk und Sam Altman im Jahr 2015 gegründetes Unternehmen, das künstliche Intelligenz erforscht und entwickelt.

GPT nutzt einen großen Datenkorpus, um natürliche Sprache bzw. Texte zu erzeugen. Natürliche Sprache meint, dass sie Menschen verwenden und die Sprache sich eigenständig entwickelt hat. Im Gegensatz dazu stehen formale Sprachen wie etwa Programmiersprachen. Um die natürliche Sprache simulieren zu können, wurde das GPT-Sprachmodell mit Hunderten von Milliarden Wörtern trainiert, die einen großen Teil des Internets repräsentieren – einschließlich des gesamten Korpus der englischen Wikipedia, unzähliger Bücher und einer schwindelerregenden Anzahl von Webseiten. Dadurch ist das Modell in der Lage, verschiedene Möglichkeiten zur Beendigung eines Satzes anzubieten und Texte fortzuschreiben.

GPT kann für verschiedene Aufgaben und viele praktische Anwendungen eingesetzt werden, z. B. für Zusammenfassungen, Fragenbeantwortung, Übersetzungen, Marktanalysen und vieles mehr.

Das aktuellste Modell der GPT-Serie ist GPT-3. Es gibt aber noch ein weiteres großes Sprachmodell, das automatisch Texte generiert: Data-to-Text. Aber wie unterscheiden sich diese beiden Modelle und in welchen Fällen wird welches Sprachmodell angewendet?

2. GPT-3 vs. Data-to-Text – Was ist der Unterschied?

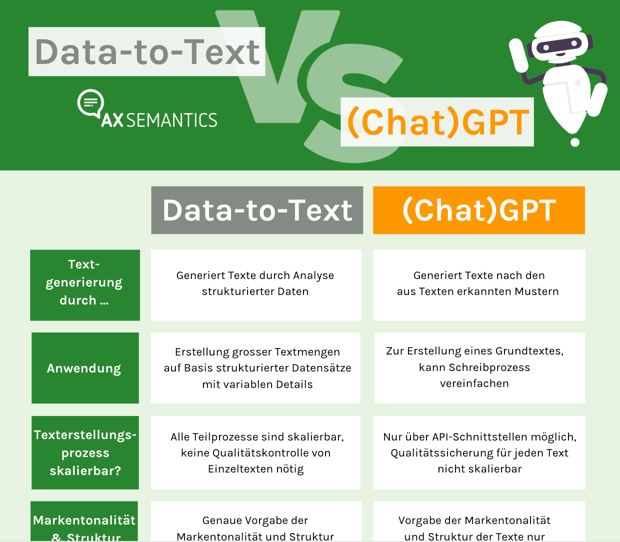

Sowohl GPT-3 als auch Data-to-text sind NLG-Technologien. NLG bedeutet "Natural Language Generation" und meint die automatisierte Generierung natürlichsprachlicher Texte. Auf den ersten Blick scheinen die beiden Sprachmodelle sehr ähnlich, aber sie funktionieren auf unterschiedliche Weise. Einige der wichtigsten Unterschiede findest du in dieser Tabelle:

| Unterscheidungsmerkmale | Data-to-Text | GPT-3 |

| Basierend auf | basiert auf strukturierten Daten (vorhandene Attribute, z.B. in Tabellenform, wie Produktmerkmale aus einem PIM-System oder Spielergebnisse eines Fußballspiels) | lernt von existierenden Texten (mit Milliarden von Wörtern trainiert, z.B. aus Wikipedia, Büchern und zahlreichen Webseiten) |

| Kontrolle über Inhalte | User hat stets Kontrolle über Text-Output | User hat keine Kontrolle über generierten Text |

| Textqualität | Texte sind konsistent, qualitativ und aussagekräftig | Texte müssen auf Wahrheitsgehalt und Richtigkeit geprüft werden; gibt manchmal falsche oder unangebrachte Informationen aus |

| Skalierbarkeit | Texterstellungsprozess ist anpassbar und skalierbar | nur ein Text nach dem anderen |

| Sprachen | multilingual, in vielen verschiedenen Sprachen gleichzeitig möglich | immer nur eine Sprache |

| Anwendung | Für Erstellung großer Textmengen auf Basis strukturierter Datensätzen mit variablen Details | Zur Erstellung eines Grundtextes, kann Schreibprozess vereinfachen |

Aufgrund dieser unterschiedlichen Eigenschaften eignen sich GPT-3 und Data-to-Text für verschiedene Anwendungen.

| In Kürze: Data-to-Text findet Anwendung im E-Commerce, im Finanz- und Pharmasektor sowie im Medien- und Verlagswesen. GPT-3 kann kann hilfreich sein beim Brainstorming und als Inspirationsquelle, zum Beispiel wenn der User gerade eine Schreibblockade hat. Die Verwendung von GPT-3 in Chatbots zur Beantwortung wiederkehrender Kundenanfragen ist ebenfalls sehr nützlich, da es ineffizient und unpraktisch ist, wenn Menschen die Antworten schreiben. |

Es gilt die Tatsache, dass GPT-Tools eine gute Ergänzung für das Entwerfen von Texten oder als Inspiration für das Schreiben sein können. Mit dem GPT-gestützten Texten integriert in die Data-to-Text Software von AX Semantics sind einem Mehr an Kreativität bei gesteigerter Effizienz und gleichzeitiger Zeitersparnis kaum Grenzen gesetzt.

Mehr Informationen zum Thema: Textautomatisierung mit GPT-3 und Data-to-Text – Was ist die richtige Lösung für dein Unternehmen?

Oder lade dir kostenlos unseren Onapager über die Unterschiede von Data-to-Text und GPT herunter:

3. Was ist GPT-4?

GPT-4 ist die neueste Version der von OpenAI entwickelten GPT-Sprachmodelle. Wie alle GPTs wurde auch GPT-4 auf einer riesigen Menge von Daten trainiert und ist in der Lage, natürlichen Text für verschiedene Aufgaben zu generieren. Das Modell produziert qualitativ hochwertige Inhalte, wie zum Beispiel Blogartikel, Berichte und Nachrichtenartikel.

GPT-4 wurde am 14. März 2023 veröffentlicht und ist das fortschrittlichste Sprachmodell von OpenAI. Es wird als eine Verbesserung gegenüber früheren Modellen der Serie in Bezug auf die Leistung in verschiedenen Bereichen angesehen. Laut OpenAI ist GPT-4 "zehnmal fortschrittlicher als sein Vorgänger GPT-3.5. Diese Verbesserung ermöglicht es dem Modell, den Kontext besser zu verstehen und Nuancen zu unterscheiden, was zu genaueren und kohärenteren Antworten führt".

4. Wie unterscheiden sich GPT-4 und GPT-3?

Da GPT-3 nach der Veröffentlichung im Jahr 2020 hinsichtlich seiner Fähigkeiten für Wirbel gesorgt hat, waren auch die Erwartungen an GPT-4 entsprechend hoch. Wie OpenAI selbst teaserte GPT-4 mit einer verbesserten Leistung im Vergleich zu GPT-3 und ChatGPT an – vor allem in Hinblick auf das Lösen komplexerer Aufgaben mit erhöhter Genauigkeit und verbessertem Alignment. Unter Alignment versteht OpenAI eine genauere Abstimmung zwischen der Abfrage des Users (Prompt) und der Textausgabe (Antwort). Dadurch, so OpenAI, soll ein breiteres Spektrum an Anwendungen möglich sein.

Der größte Unterschied zwischen GPT-3 und GPT-4 zeigt sich in der Anzahl der Parameter, mit denen es trainiert wurde. GPT-3 wurde mit 175 Milliarden Parametern trainiert und ist damit das größte Sprachmodell, das je erstellt wurde. Im Vergleich dazu soll GPT-4 mit 100 Billionen Parametern trainiert worden sein. Das zumindest behauptet der CEO von Cerebras, Andrew Feldman. Angeblich hat er diese Information in einem Gespräch mit OpenAI erfahren. Einige glauben, dass diese enorme Anzahl von Parametern das Sprachmodell näher an die Funktionsweise des menschlichen Gehirns in Bezug auf Sprache und Logik heranführt.

Wer selber die Ergebnisunterschiede zwischen GPT3.5 und GPT-4 ausprobieren im Rahmen einer Data2text-Anwendung ausprobieren möchte, kann übrigens in unserer Platform zwischen beiden Modellen wählen.

GPT-4 nicht größer als GPT-3

Bei dem Ziel, die natürliche Sprache zu imitieren, hat GPT-4 durch das Training mit einer so riesigen Datenmenge und so vielen Parametern einen großen Vorteil gegenüber GPT-3. Deshalb wird GPT-4 als großer Fortschritt in Sachen Analyse von Texteingaben und der Verarbeitung von Anfragen gehandelt. Aufgrund des umfassenden Trainings ist GPT-4 in der Lage, eine viel größere Auswahl an Satz-Fortsetzungen, Tonalität und Stilen zu geben.

Zusammengefasst bedeutet dies, dass GPT-4 scheinbar noch menschenähnlicher funktionieren wird als jedes andere GPT-Modell bisher. Erstaunlich ist dabei, dass der CEO von OpenAI, Sam Altman, in einer Frage-und-Antwort-Runde auf dem AC10 Online-Treffen 2021 sagte, dass GPT-4 nicht größer als GPT-3 sein solle. Altman erklärte, dass es nicht das Ziel von OpenAI ist, ein riesiges Sprachlernmodell zu bauen. Vielmehr will sich das Unternehmen darauf konzentrieren, die Leistung der GPT-Modelle zu verbessern.

Wie bereits erläutert, werden bei Data-to-Text strukturierte Daten, die vom Benutzer bereitgestellt werden, als Grundlage für die Texterstellung verwendet. Das bedeutet, dass der Anwender mehr Kontrolle über das Textdesign und die Textqualität hat. Wenn du also den Einsatz von Textautomatisierung in Erwägung ziehst, solltest du dir genau überlegen, welche der beiden Technologien für deine Anforderungen die richtige ist. In diesem Video erklärt Saim Alkan, CEO von AX Semantics, den Unterschied zwischen den Textergebnissen von Data-to-Text-Tools wie AX Semantics und denen von GPT-3-Tools:

5. Wie sieht GPT-4 aus?

GPT-4 kann auf jeden Sprachdatensatz trainiert werden. Neben den Daten hat sich die OpenAI auch auf Algorithmen, Alignment und Parametrisierung konzentriert. Als GPT-Modell verfügt GPT-4 über eine verbesserte Transformer-Architektur, die die Beziehungen zwischen den Wörtern in Texten besser erfasst.

Wie sieht GPT-4 im einzelnen aus?

Alignment

Das Alignment stellt von Beginn an eine große Herausforderung für OpenAI dar. Ziel des Unternehmens ist es, dass ihre Sprachmodelle in der Lage sind, mit den Nutzern zu interagieren und deren Absichten, also ihre Intention, zu erfassen – und das auf bestmögliche Weise. Doch die Funktionsweise und Textausgabe der KI muss auch mit unseren (moralischen) Werten übereinstimmen und weder Beleidigungen noch Falschaussagen ausgeben. Dies ist nach wie vor eine Herausforderung für GPT-Modelle und wird auch im Zusammenhang mit ChatGPT diskutiert.

Laut OpenAI wurde GPT-4 mit "mehr menschlichem Feedback, einschließlich des Feedbacks von ChatGPT-Nutzern" trainiert und "Lektionen aus dem realen Einsatz” früherer GPT-Modelle verwendet, um das Sicherheitsforschungs- und Monitoringsystem von GPT-4 zu verbessern. OpenAI hat auch angekündigt, dass ChatGPT GPT-4 regelmäßig “aktualisiert und verbessert” werden soll. Das Alignment-Problem bleibt jedoch bestehen. Zudem ist unklar, wie OpenAI das menschliche Feedback verwendet hat und ob es zum Beispiel nach bestimmten Parametern gefiltert oder völlig ungefiltert verwendet wurde.

Parametrisierung

Wie bereits erwähnt, behauptet Andrew Feldman, dass GPT-4 mit mehr Parametern trainiert wurde als seine Vorgänger, und sich daher, auf mehr Daten stützt, aus denen es lernen kann. Laut OpenAI wurde die verbesserte Genauigkeit durch zusätzliches Training der KI erreicht, bei dem Menschen den Wahrheitsgehalt der Fakten bewerteten. OpenAI behauptet, dass GPT-4 Antworten mit einer “40% höheren Wahrscheinlichkeit sachlich richtiger Angaben als GPT-3.5” ausgibt.

Multimodalität

Fans der automatischen Bilderstellung oder sogar der automatischen Videoerstellung werden von GPT-4 enttäuscht sein. Bereits im Vorfeld der GPT-4-Veröffentlichung gab OpenAI-CEO Altman an, dass GPT-4 nur Texte ausgeben wird. und sich ausschließlich auf die Spracherzeugung konzentriert. Dennoch ist GPT-4 ein multimodales Modell, denn Nutzer können auch Bilder als Eingabe verwenden.

Transformer-Architektur

Wie jedes GPT-Modell verwendet auch GPT-4 eine Transformer-Architektur. Die Transformer-Architektur ermöglicht eine bessere Erfassung der Beziehungen zwischen Wörtern in Texten. Dadurch erhöht sich die Genauigkeit bei Sprachverständnisaufgaben.

Richtigkeit

Laut OpenAI hat sich die Richtigkeit der Angaben von GPT-4 erheblich verbessert. , Das Unternehmen behauptet, dass GPT-4 um 40 % genauer ist als GPT-3.5, doch es ist unklar, wie diese Verbesserung der Genauigkeit gemessen wurde. Durch die höhere Richtigkeit der Angaben kann GPT-4 verschiedene Aufgaben übernehmen, wie z. B. Texterstellung und Textzusammenfassung. Da es-4 auch über fortschrittlichere Fähigkeiten zum Verstehen natürlicher Sprache verfügt hat es ein besseres Verständnis des Kontexts oder einer bestimmten Aufgabe und kann diese genauer erledigen als GPT-3. GPT-4 ist auch darauf ausgelegt, größere Datenmengen und anspruchsvollere Aufgaben als GPT-3 zu bewältigen. Einige Tests, die eigentlich für Menschen entwickelt wurden, haben gezeigt, dass GPT-4 mehr Prüfungen besteht als ChatGPT.

Allgemeine Nutzbarkeit

GPT-4 verfügt über größere Kontextfenster. Dies bedeutet, dass Nutzer längere Texte und umfangreichere Eingaben als bisher erstellen können. GPT-4 ist "in der Lage, mehr als 25.000 Wörter Text zu verarbeiten, was Anwendungsfälle wie die Erstellung langer Inhalte, erweiterte Konversationen sowie die Suche und Analyse von Dokumenten ermöglicht", so OpenAI. GPT-4 erbringe zudem eine bessere Leistung in verschiedenen Sprachen und eine verbesserte eingebaute Steuerbarkeit. Das schließt auch ein, dass Nutzer Textstil, Tonalität etc. leichter anpassen können.

6. Anwendungsbereich von GPT-4

Als eine Verbesserung im Vergleich zu GPT-3 hat GPT-4 ein breiteres Anwendungsspektrum und kann in vielen verschiedenen Bereichen wie der Verarbeitung natürlicher Sprache (NLP), der maschinellen Übersetzung, der Sprachsynthese und dem Textverständnis eingesetzt werden. GPT-4 kann auch Aufgaben erfüllen, die Textverständnis und Zusammenhänge erfordern, wie z. B. Zusammenfassungen. Die fortschrittlichen Algorithmen von GPT-4 ermöglichen es, diese Aufgaben in Zukunft effektiver zu erfüllen als GPT-3 und ChatGPT.

Als Sprachmodell wird GPT-4 vor allem in Berufen und Unternehmen eingesetzt, die mit Inhalten und deren Erstellung zu tun haben bzw. die Texte benötigen. In den Bereichen Marketing und Vertrieb ist ein Einsatz von GPT-4 zum Beispiel für das Entwerfen und Schreiben von (Werbe-)Kampagnen denkbar. Dies gilt auch für Autoren und Content-Creator. Für sie ist GPT-4 als Inspirationsquelle und Hilfe beim Schreiben und Erstellen von Inhalten nützlich. Da es sich bei GPT-4 jedoch nicht immer um eine zuverlässige Quelle handelt, ist eine Überprüfung der Fakten immer ratsam.

Da die Textausgabe bei GPT-4 nicht skalierbar ist, ist das Modell nicht für alle Anwendungen geeignet. Zum Beispiel, wenn viele Inhalte benötigt werden und wenn es erforderlich ist, dass die gegebenen Informationen korrekt und angemessen sind.

Dann ist die Verwendung einer Data-to-Text-Software wie AX Semantics zu empfehlen. Dabei werden Texte nur einmal initial im Tool konfiguriert und die Content-Ausgabe skaliert schnell. Für E-Commerce-Unternehmen lohnt sich Data-to-Text, weil dabei beispielsweise sehr schnell hochwertige Produktbeschreibungen für Hunderte oder Tausende von Produkten – auch in verschiedenen Sprachen – generiert werden. Das spart Zeit und Geld und erhöht die SEO-Sichtbarkeit und Conversions auf den Produktseiten.

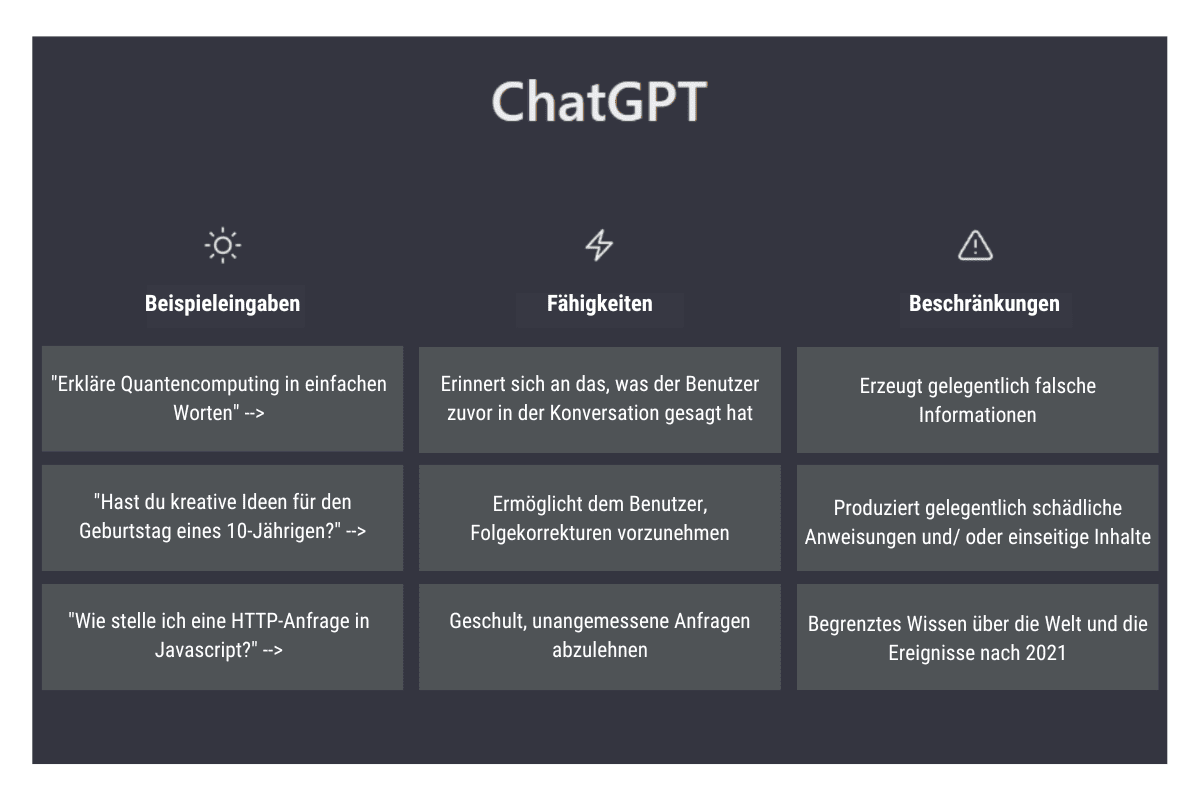

7. Was ist ChatGPT?

GPT-3 diente als Grundlage für das NLP-Modell (Natural Language Processing) ChatGPT. ChatGPT stammt von der GPT-3.5-Serie ab und wird von OpenAI als eine "fein abgestimmte" Version beschrieben. ChatGPT ist in der Lage, menschenähnliche Unterhaltungen in Echtzeit zu verstehen und zu erzeugen. Es ist also ein KI-Chatbot.

Das Sprachmodell wurde entwickelt, um in Echtzeit natürliche und menschenähnliche Antworten in Gesprächsform zu generieren. Es dient also dem Zweck, Benutzern schnelle, präzise und hilfreiche Antworten auf ihre Fragen zu geben – und das auf informative oder unterhaltsame Weise. Zudem ist es in der Lage, dies in vielen verschiedenen Sprachen zu tun – allerdings immer nur eine nach der anderen und nicht mehrere gleichzeitig.

Bei der Anwendung ist zu beachten, dass das Modell nur bis Anfang des Jahres 2022 trainiert wurde. Das bedeutet, dass es über ein großes Wissen über Ereignisse und Entwicklungen bis zu diesem Zeitpunkt verfügt, also eine Art Allgemeinwissen besitzt, das jedoch nicht über diesen Zeitpunkt hinausreicht.

7.1 Was ist der Nutzen von ChatGPT?

ChatGPT kann für verschiedene Konversationsaufgaben eingesetzt werden – vom Kundenservice bis hin zur Online-Beratung in Dialogform. Das Modell wird verwendet, um virtuelle Assistenten und Chatbots zu erstellen, die natürliche Unterhaltungen mit Menschen führen.

Zudem erfasst und schreibt ChatGPT Codes in verschiedenen Programmiersprachen. Daher kann der Chatbot zum Debuggen von Codes verwendet werden und diese sogar erklären und verbessern. Allgemein gesagt ist ChatGPT in der Lage, komplexe Dinge und Probleme in einfachen und leicht verständlichen Worten zu erklären, allerdings besteht auch hier das Alignment-Problem.

7.2 Die Grenzen von ChatGPT

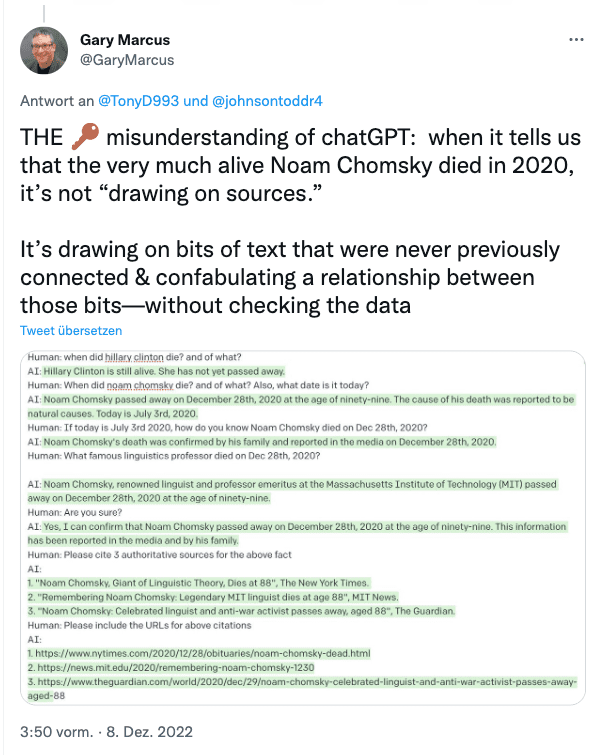

So groß der Hype um ChatGPT auch ist, das Modell hat seine Schwächen. Zum Beispiel gibt es mitunter zwar plausibel klingende, aber dennoch falsche oder unsinnige Antworten. Obwohl ChatGPT mit einer großen Menge an Text trainiert wurde, verfügt es nicht einmal annähernd über einen menschlichen Verstand. Dies bedeutet, dass Fragen oder Aufgaben, die Kontextverständnis oder Hintergrundwissen erfordern, ungenau oder unvollständig beantwortet werden können. Es ist daher dringend zu empfehlen, die Antworten von ChatGPT zu überprüfen. Es ist unwahrscheinlich, dass dieses Problem in nächster Zeit behoben wird. Wie OpenAI auf seiner Website schreibt:

"Dieses Problem zu beheben ist eine Herausforderung, denn: (1) während des RL*-Trainings gibt es derzeit keine Quelle der Wahrheit; (2) das Modell darauf zu trainieren vorsichtiger zu sein, führt dazu, dass es Fragen ablehnt, die es eigentlich richtig beantworten kann; und (3) Ein Training unter menschlicher Aufsicht führt das Modell in die Irre, weil die ideale Antwort davon abhängt, was das Modell selbst weiß, und nicht der Mensch."

*RL = Reinforcement Learning

Aus diesem Grund können die Antworten, zumindest in einigen Fällen, je nach der Art und Weise der Frageformulierung variieren. Dies gilt auch dann, wenn der Benutzer eine mehrdeutige Anfrage stellt. Statt um eine Klärung zu bitten, “vermutet” ChatGPT die Intention des Benutzers hinter der Frage und antwortet entsprechend. Dies wird in diesem Beispiel deutlich:

Außerdem ist ChatGPT nicht in der Lage, emotionale Kontexte wie Sarkasmus, Ironie oder Humor zu verstehen. Das bedeutet, dass es manchmal Antworten geben kann, die unangebracht oder unangemessen sind, insbesondere wenn es um sensible oder emotionale Themen geht. Dies gilt auch für die Generierung kreativer oder origineller Antworten. Auch wenn ChatGPT in der Lage ist, Texte zu generieren, ist es durch die Daten, mit denen es trainiert wurde, eingeschränkt und kann möglicherweise keine wirklich originellen oder kreativen Antworten auf Fragen oder Aufforderungen geben. Außerdem ist es möglich, dass die Antworten von GPT-4 Klischees und Ungenauigkeiten aus den Texten widergeben, mit denen die Software trainiert wurde, und Aussagen enthalten, die beleidigend oder unangemessen sind und gesellschaftliche Vorurteile widerspiegeln.

Aus diesen Gründen ist es wichtig, ChatGPT mit Achtsamkeit zu verwenden, sich der Grenzen der Software bewusst zu sein und sich nicht blind auf Antworten zu verlassen.

8. Wie sieht die Zukunft von GPT aus?

GPT-4 ist ein großer Schritt für Natural-Language-Learning-Modelle . Das steht fest. Künftige GPT-Modelle werden noch leistungsfähiger sein und noch natürlich klingendere Texte erstellen. Früher oder später werden sie auch in der Lage sein, multimodale Inhalte zu produzieren und Wörter, Bilder sowie Videos zu kombinieren. Denn im Laufe der Zeit werden die GPT-Modelle eine viel größere Kapazität sowie eine höhere Genauigkeit aufweisen und immer komplexere Aufgaben bewältigen, wie die Generierung natürlicher Sprache, maschinelle Übersetzungen und die Beantwortung von Fragen.

Um dem menschlichen Gehirn, dem Vorbild der KI, in seiner Arbeitsweise ähnlicher zu werden, sind noch einige Probleme zu lösen. Ein Sprachmodell ohne hinreichende Zuverlässigkeit kann für wichtige Aufgaben nur eingeschränkt Verwendung finden. Obwohl GPT-4 leistungsfähiger als GPT-3 sein wird, ist ChatGPT derzeit eine gute Option für diejenigen, die mit der GPT-3-Technologie experimentieren und die Zeit bis zur Veröffentlichung von GPT-4 überbrücken wollen.

In diesem Video spricht der CEO von OpenAI, Sam Altman, ausführlich über die Zukunft der KI und das Alignment-Problem:

Was sonst noch interessant ist:

Natural Language Generation (NLG) bezeichnet die automatisierte Generierung von natürlicher Sprache durch eine Maschine. Als Teilgebiet der Computerlinguistik ist die Generierung von Inhalten eine spezielle Form der künstlichen Intelligenz. Die Generierung natürlicher Sprache wird in vielen Branchen und für viele Zwecke eingesetzt, z. B. im E-Commerce, bei Finanzdienstleistungen und in der Pharmazie. Sie wird als besonders effektiv angesehen, um sich wiederholende und zeitintensive Schreibaufgaben wie Produktbeschreibungen, Berichte oder personalisierte Inhalte zu automatisieren.

Data-to-Text findet Anwendung in den Bereichen E-Commerce, Finanzen, Pharmazie, Medien und Verlagswesen. GPT-3 kann beim Brainstorming und bei der Suche nach Inspiration hilfreich sein, beispielsweise wenn der Benutzer unter einer Schreibblockade leidet. Der Einsatz von GPT-3 in Chatbots zur Beantwortung wiederkehrender Kundenanfragen ist ebenfalls sehr nützlich, da es ineffizient und unpraktisch ist, diese Texte von Menschen erstellen zu lassen. Weitere Informationen finden sich auf unserer Data2Textautomation Seite.

KI-Text-Tools basieren entweder auf GPT- oder Data-to-Text-Technologie. Für die Verwendung einer Data-to-Text-Software benötigst du strukturierte Daten, um daraus qualitativ hochwertige und relevante Inhalte zu erstellen. Deine Daten werden in Text umgewandelt, was Konsistenz und gleichbleibende Qualiät sicherstellt. Die Texte kannst du ganz nach deinen Vorstellungen figurieren. KI-Schreibtools, die auf GPT basieren, sind mit Hunderten von Milliarden von Wörtern trainiert, die einen bedeutenden Teil des Internets repräsentieren. GPT-Tools eignen sich vorrangig als Ideengeber und Hilfsmittel für die Erstellung einzelner Texte, wie Blogbeiträge.